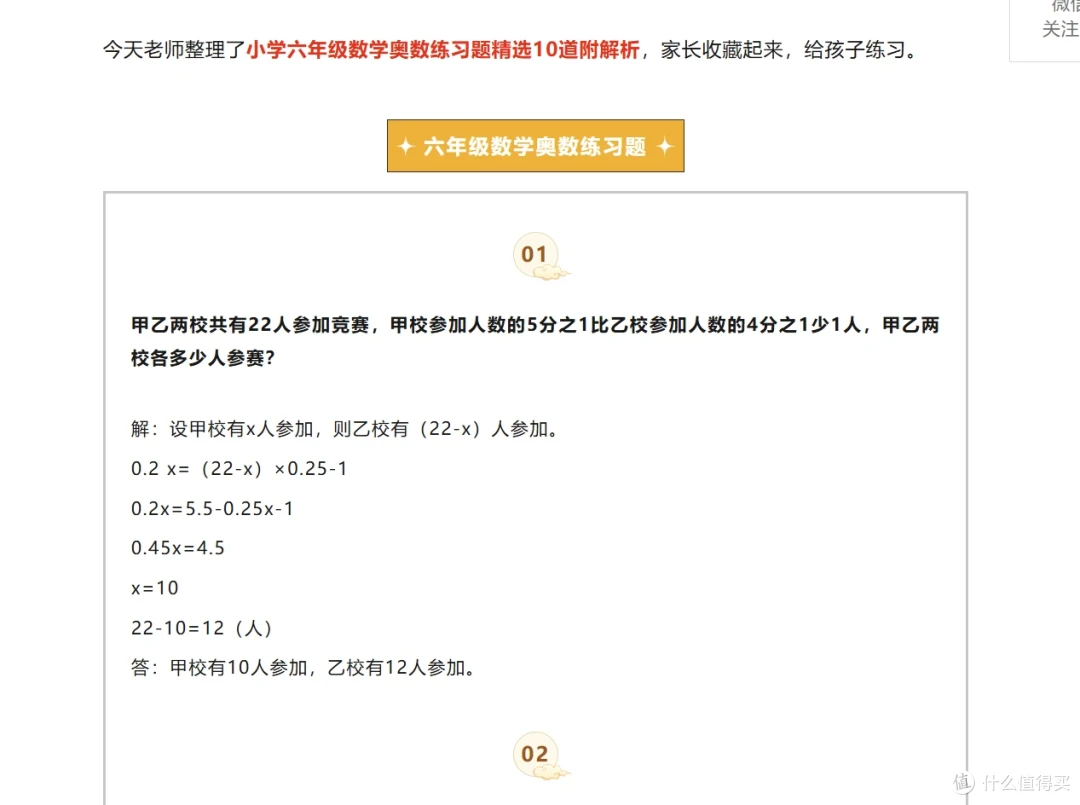

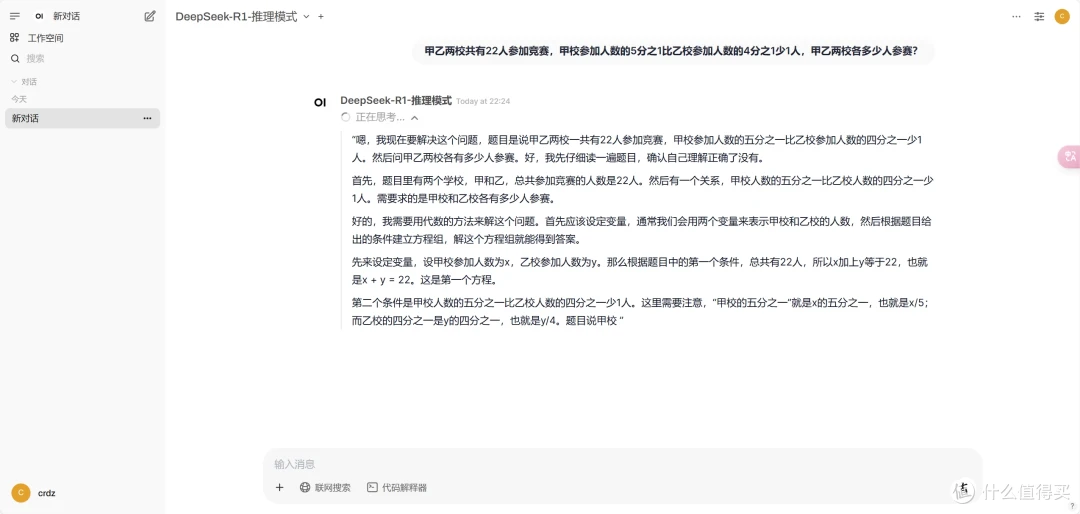

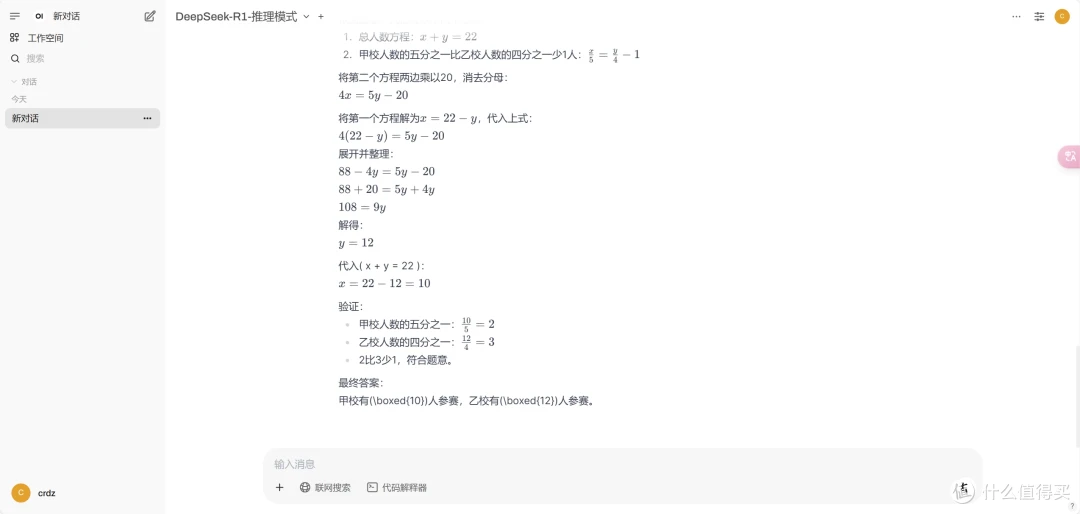

DeepSeek+本地知识库:真的太香了

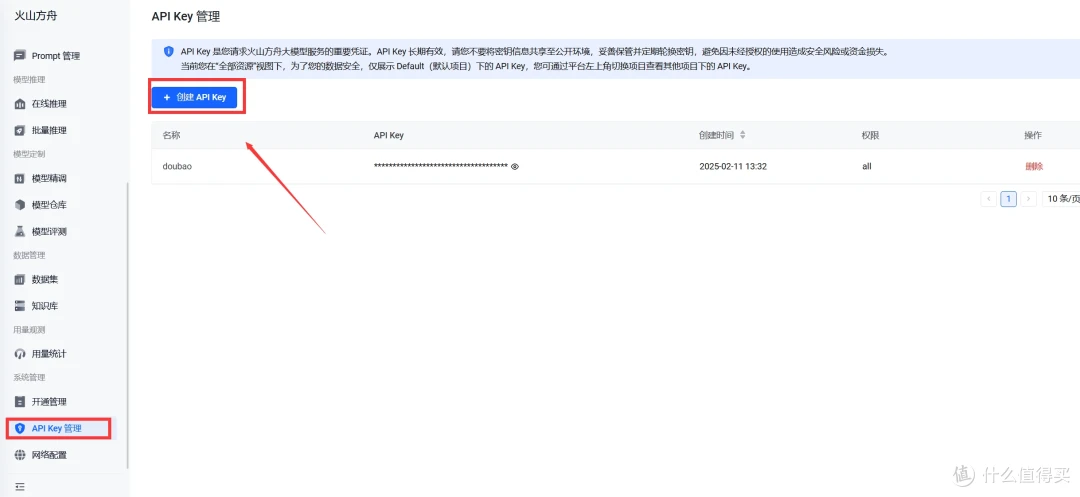

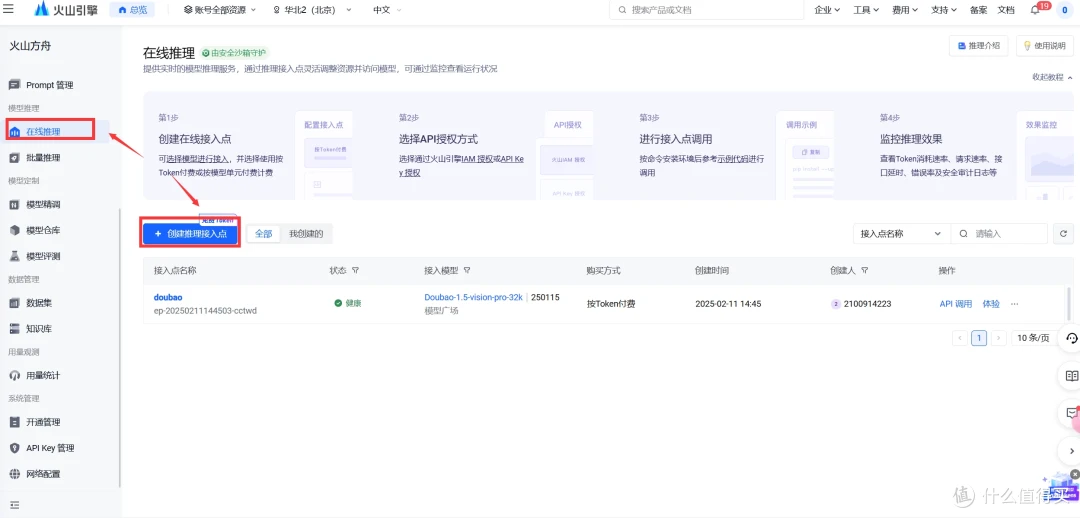

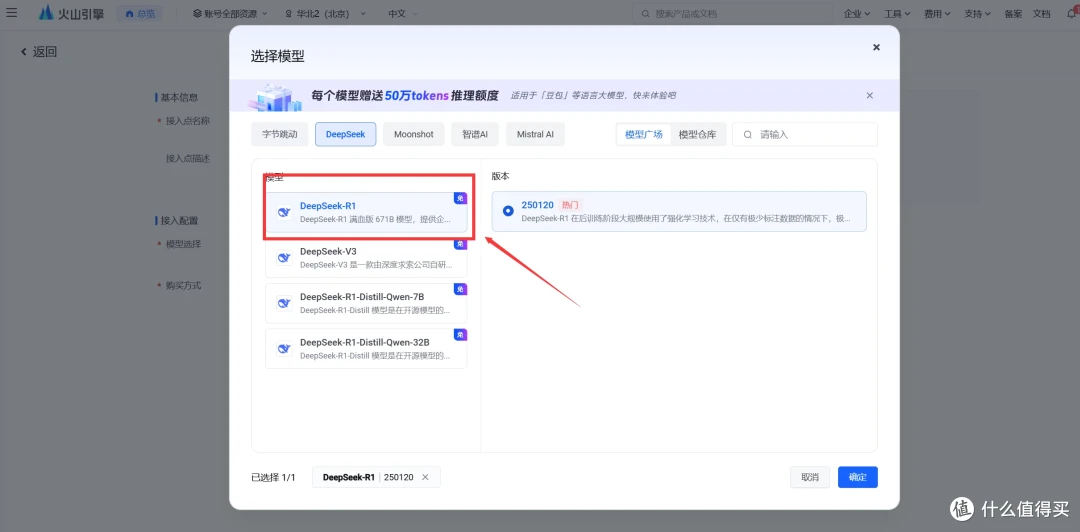

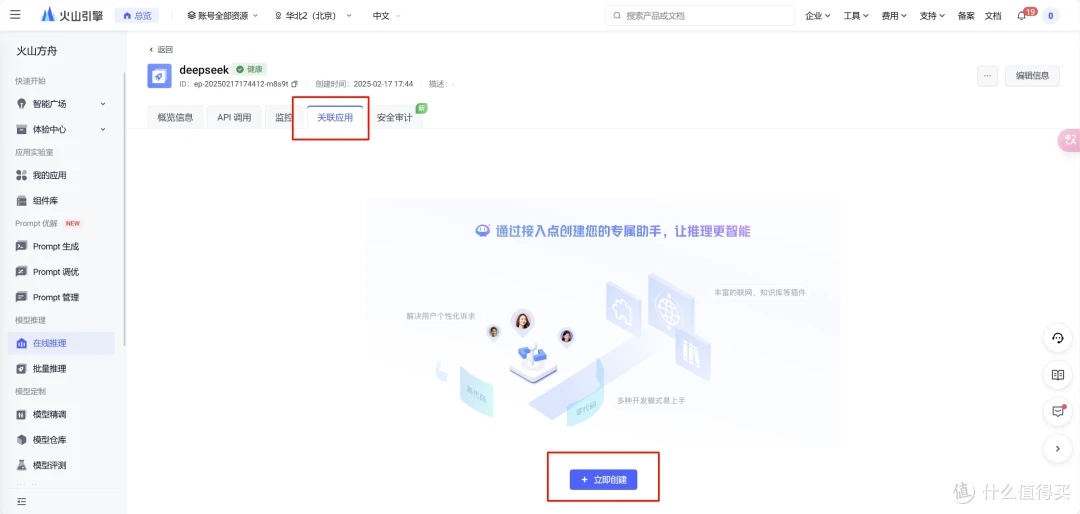

上篇分享了 国产AI之光!DeepSeek本地部署教程,效果媲美GPT-4,今天分享下deepseek +本地知识库的部署。 先画个数据流程流程。 基于本地的deepseek搭建个人知识库。 使用本地服务,安装嵌入模型,用于将文本数据转换为向量标识的模型。 根据自己的环境下载cherry studio 操作步骤:基于Cherry Studio搭建(首选)

#命令行窗口执行拉取下即可。

ollama pull bge-m3

pulling manifest

pulling daec91ffb5dd... 100% ▕████████████████████████████████████████████████████████▏ 1.2 GB

pulling a406579cd136... 100% ▕████████████████████████████████████████████████████████▏ 1.1 KB

pulling 0c4c9c2a325f... 100% ▕████████████████████████████████████████████████████████▏ 337 B

verifying sha256 digest

writing manifest

success下载cherry studio

本地模型知识库

配置本地ollama

知识库配置

cherry可以添加文档,也可以添加目录(这个极其方便),添加完以后出现绿色的对号,表示向量化完成。 大家可以看到deepseek已经把结果整理了,并告诉了我们参考了哪些资料。 差别就是大模型的选择,在模型服务里配置下在线的deepseek服务即可。 如果你的知识库有隐私数据,不要联网!不要联网!不要联网! 下载以后,安装的时候,注意安装到其他磁盘,不要在c盘安装。 将文档拖拽到上传框。ps: 只需要拖拽一次就行了,它在聊天框能看到。不知道为什么,我这拖拽以后,没看到上传成功,然后又拖拽了几次。然后聊天框就好多份。 当然你可以配置远程文档,confluence、github都可以。 ps: 需要注意的是文档在工作区间内是共用的。 AnythingLLM 可以提供api访问的功能,这个可以作为公共知识库使用。 整个操作下来,AnythingLLM 的体验没有cherry好。AnythingLLM就像一个包壳的web应用(后来查了下,确实是)。AnythingLLM 得具备一定的程序思维,给技术人员用的。非技术人员还是使用cherry吧。作为喜欢折腾的开发人员,我们可以结合dify使用。添加知识文档

搜索验证

大模型处理

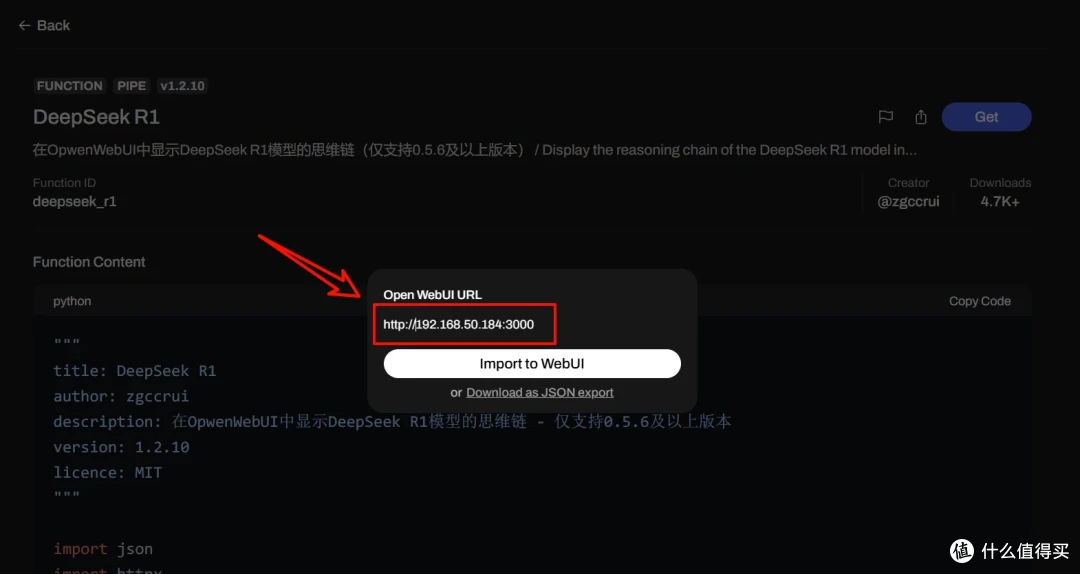

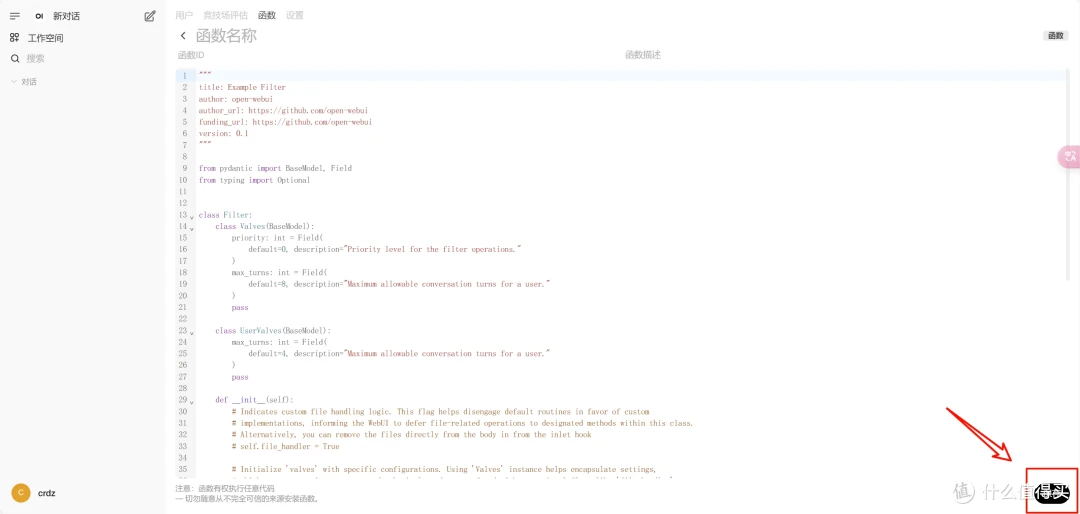

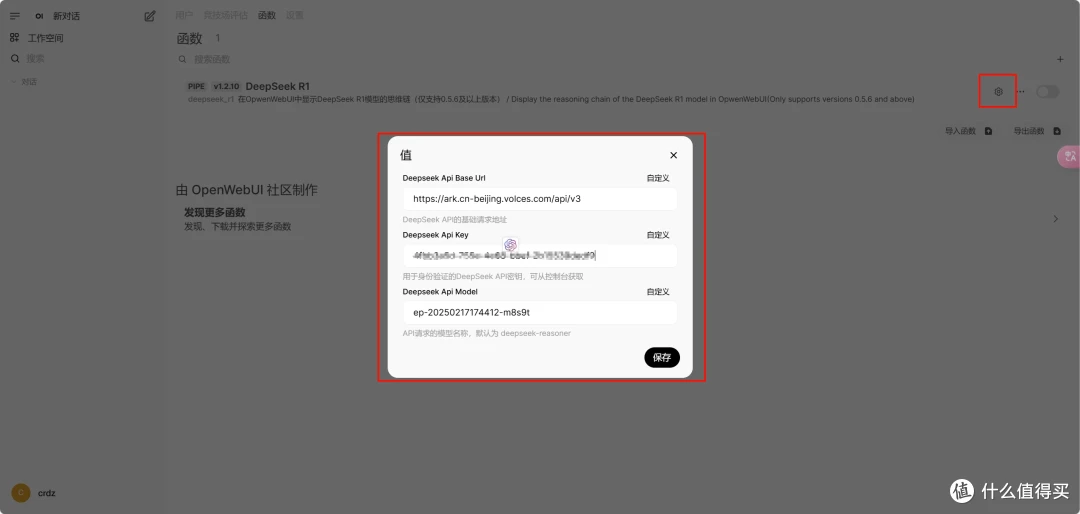

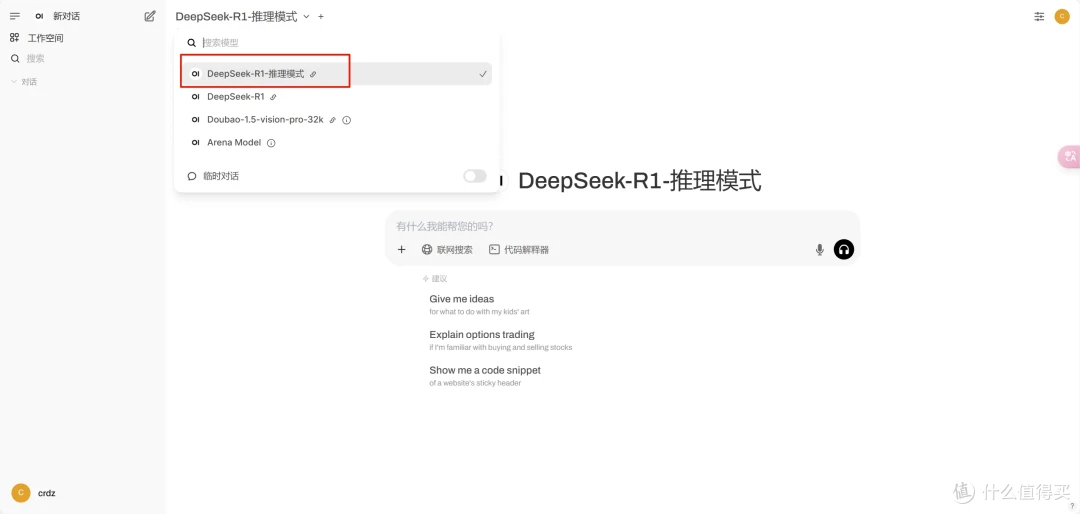

满血版

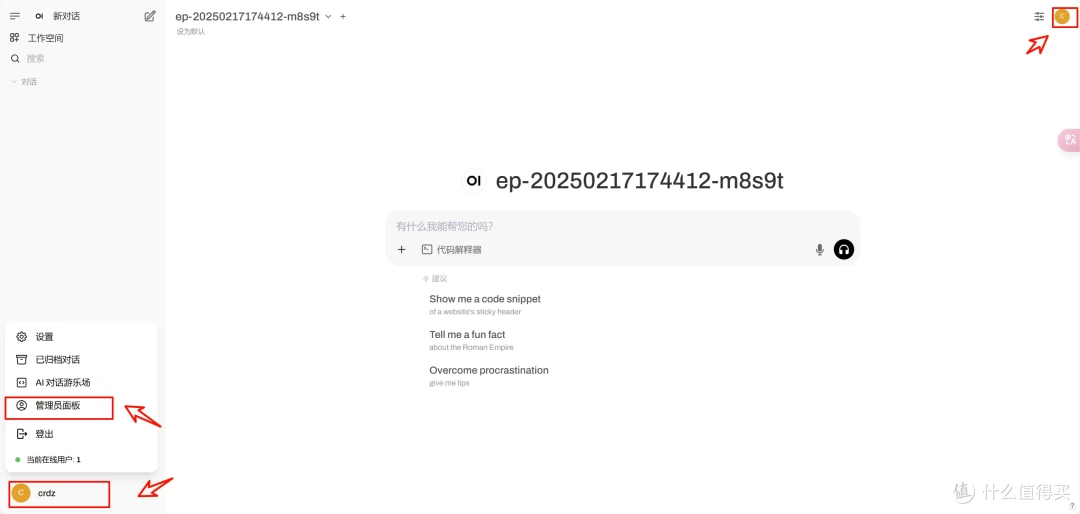

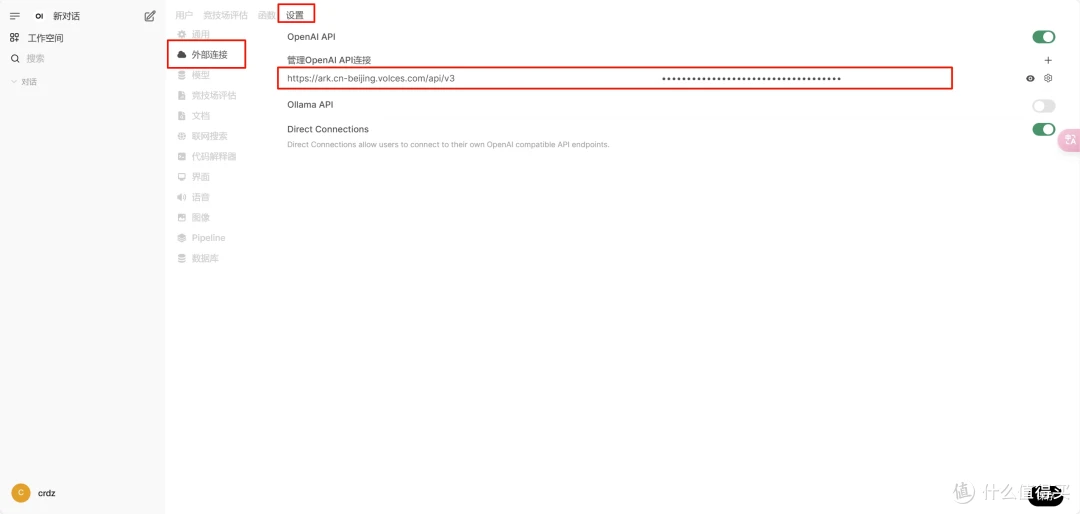

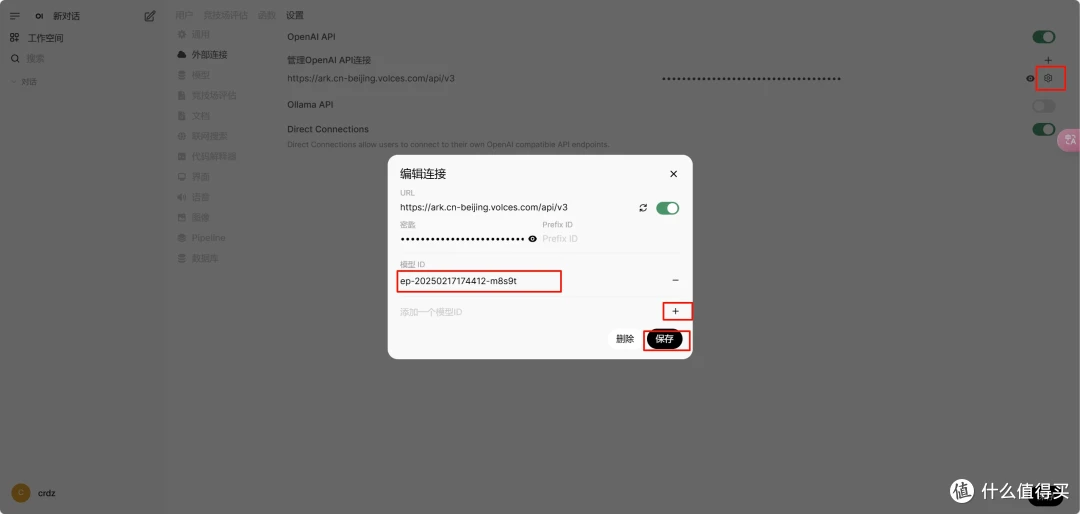

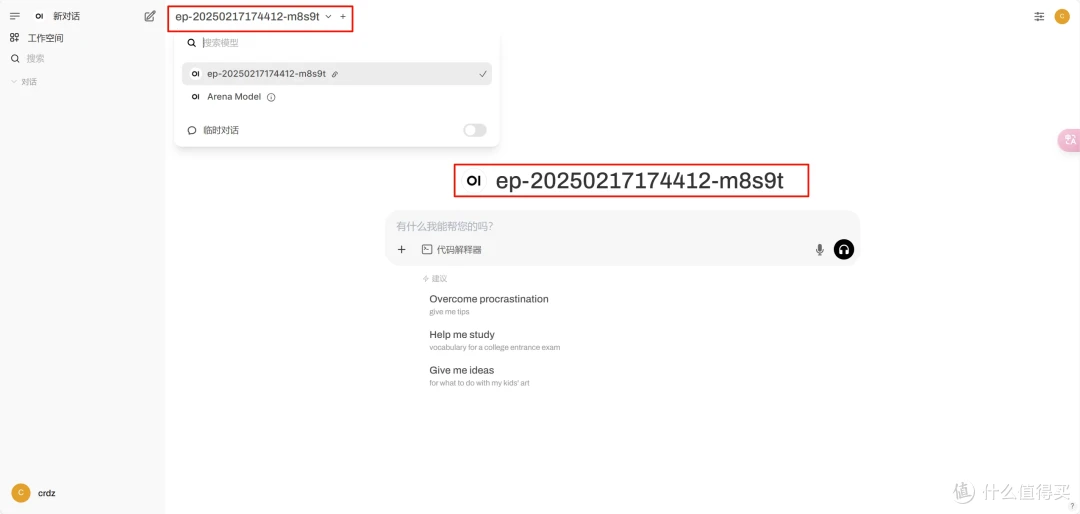

方案二 基于AnythingLLM搭建

下载AnythingLLM Desktop

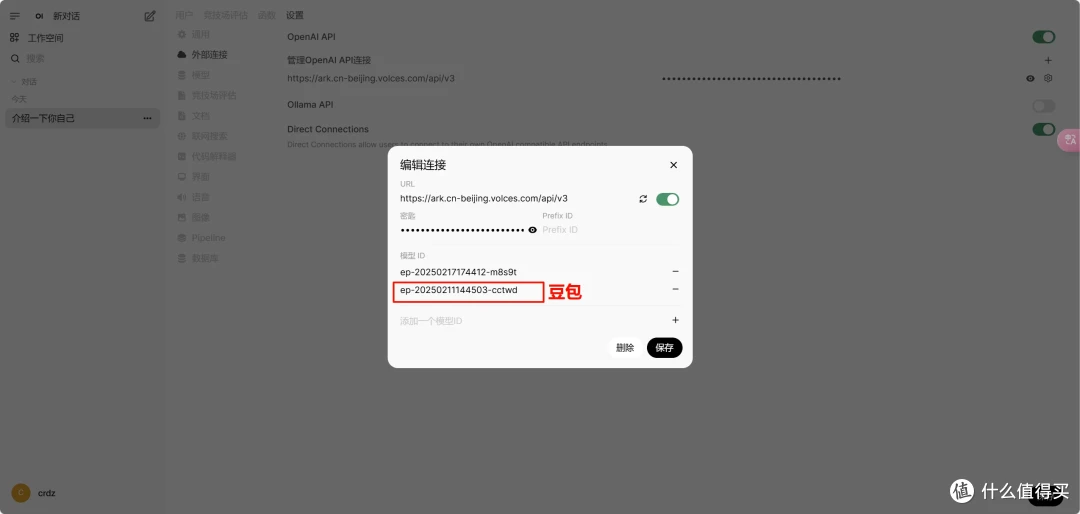

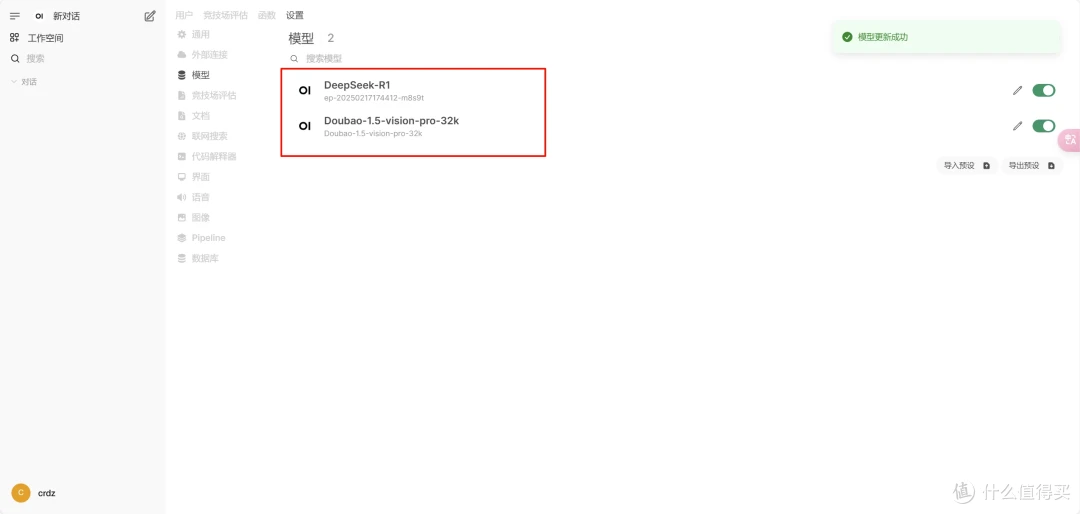

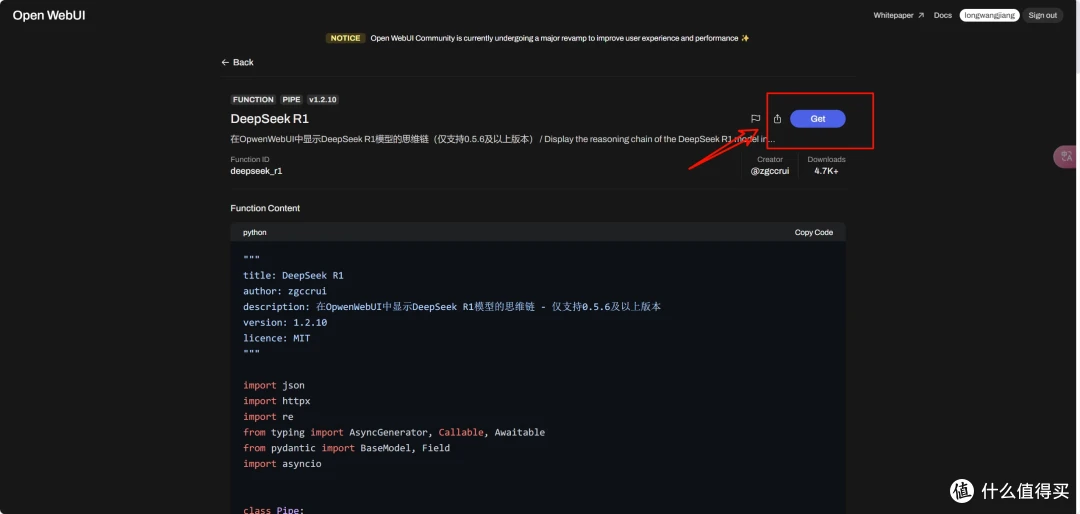

AnythingLLM 配置

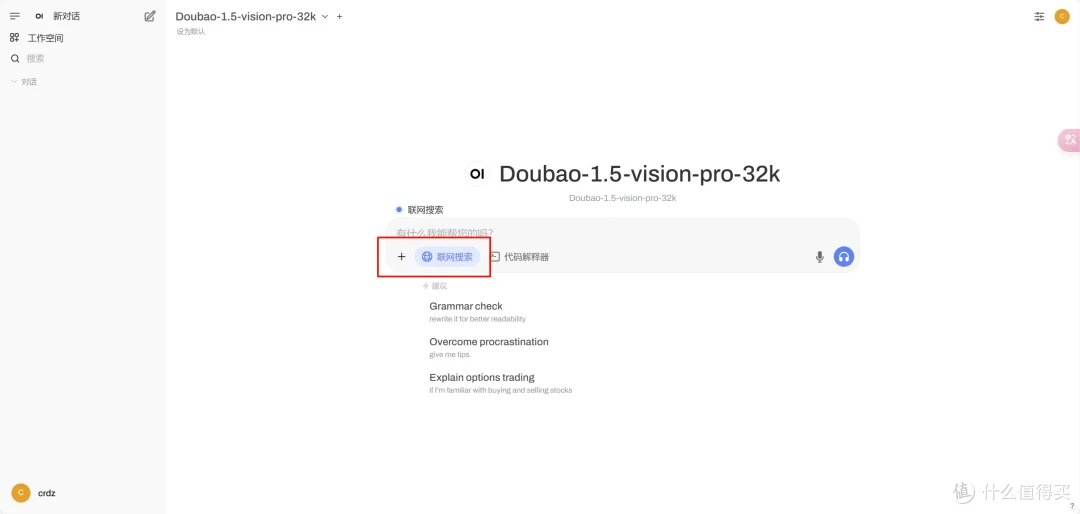

配置工作区

api功能

总结

销售充电站知识库界面

销售充电站知识库界面