既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

需要这份系统化的资料的朋友,可以戳这里获取

运维工程师—李晨星

文章目录

一、虚拟化

1. 什么是虚拟化

2. 虚拟化软件的差别

二、XenServer服务器虚拟化平台

1. 首先从Xen开始说起

2. XenServer介绍

3. Xen与XenServer的区别

4. XenServer主机系统要求

三、XenServer 安装步骤

1. 版本选择

2. 主机系统要求

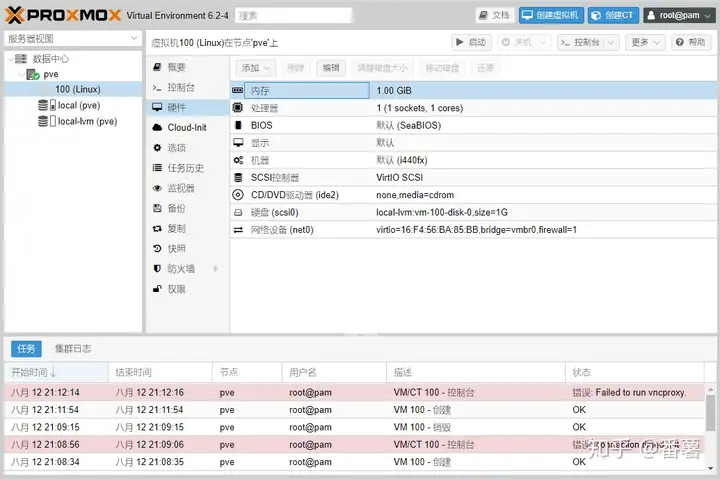

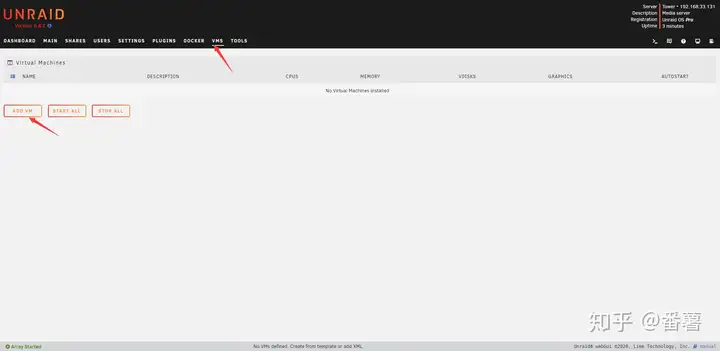

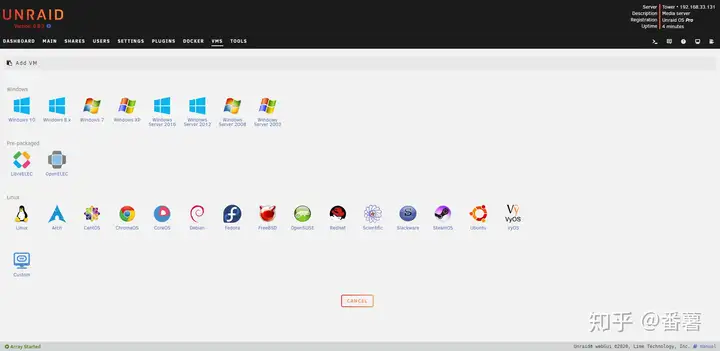

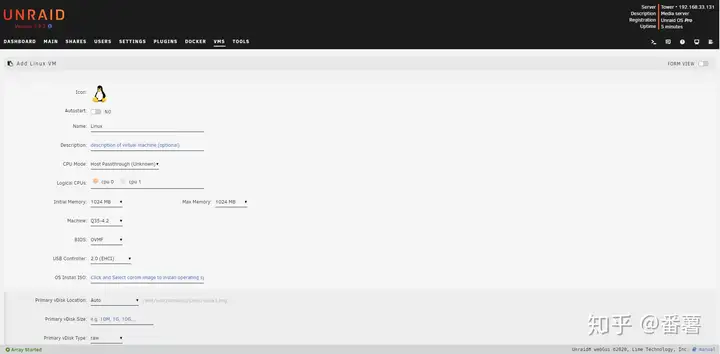

3. 新建虚拟机

4. XenServer引导安装

5. 管理XenServer的方式

三、客户端管理软件—XenCenter汉化版的安装

四、配置XenServer的YUM源

五、XenServer安装Centos8 虚拟机

1. 安装规划

2. 安装步骤规划

3. 创建ISO镜像库

3.1 创建windows共享的ISO库

4. 新建虚拟机,按步骤配置

5. VM虚拟机创建完成

6. 使用Xshell连上Centos8-node1虚拟机,进行基本的设置与生成快照

7. 利用快照文件快速的添加新的VM

8. 安装 XenServer Tools

六、VM虚拟机的复制、导入导出

七、虚拟机模板创建与使用

八、管理和配置存储

1. 本地存储

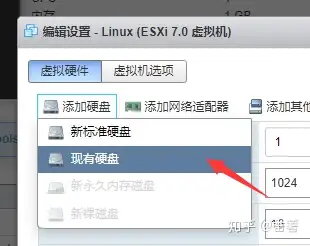

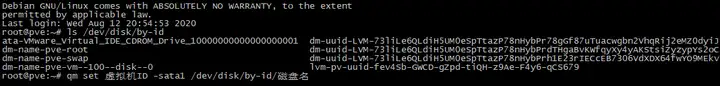

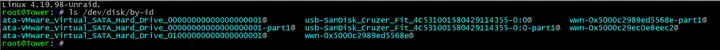

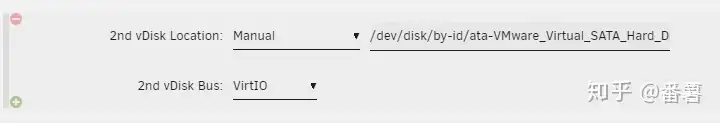

1.1 如果虚拟机的内存不够了,可以在存储中添加新的硬盘

1.2 磁盘的分离与连接

2. 配置网络存储

2.1 下载starwind工具

2.2 创建管理控制台

2.3 回到XenCenter上创建存储库

3. NFS 存储

1. 搭建nfs服务器

2. 创建存储库并应用

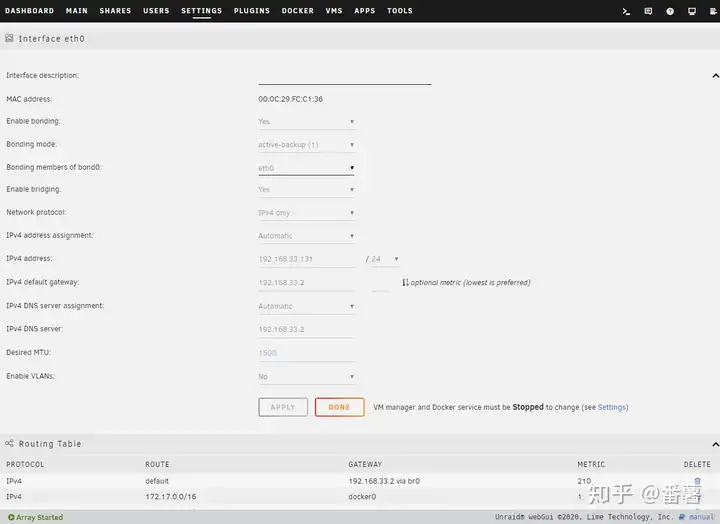

九、管理和配置网络

1. 准备网络环境

1. 外部网络

2. 单服务器专用网络

3. 绑定网络

4. 跨服务器专用网络

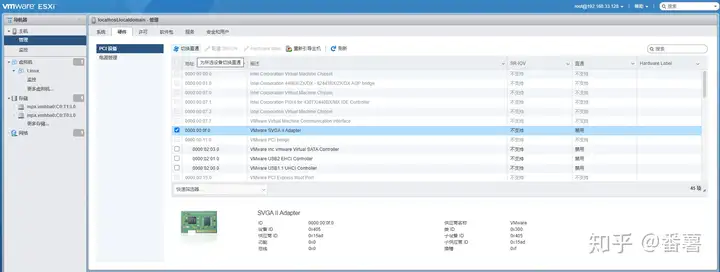

5. SR-IOV网络

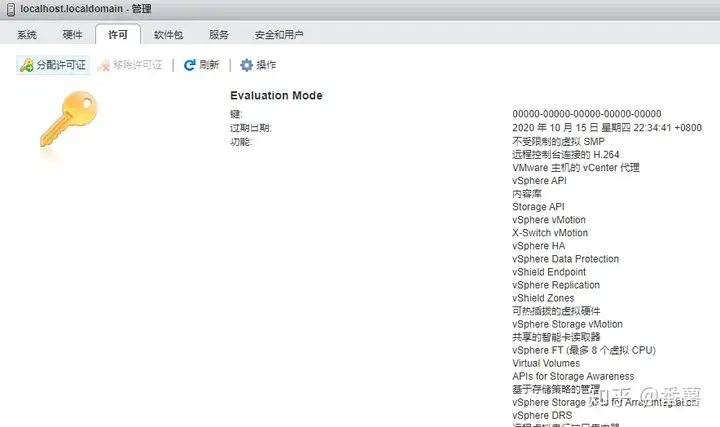

十、管理许可证

1. 免费许可证现在已经无法激活

十、资源池管理

1. 创建资源池

十一、使用XenConvert把实体计算机转为虚拟机

十二、XenServer的高可用和负载均衡

高可用性

负载均衡

十三、配置VM保护策略和 vApp

1. 配置VM保护策略

2. vApp

十四、XenServer的更新

十五、XenServer的管理命令

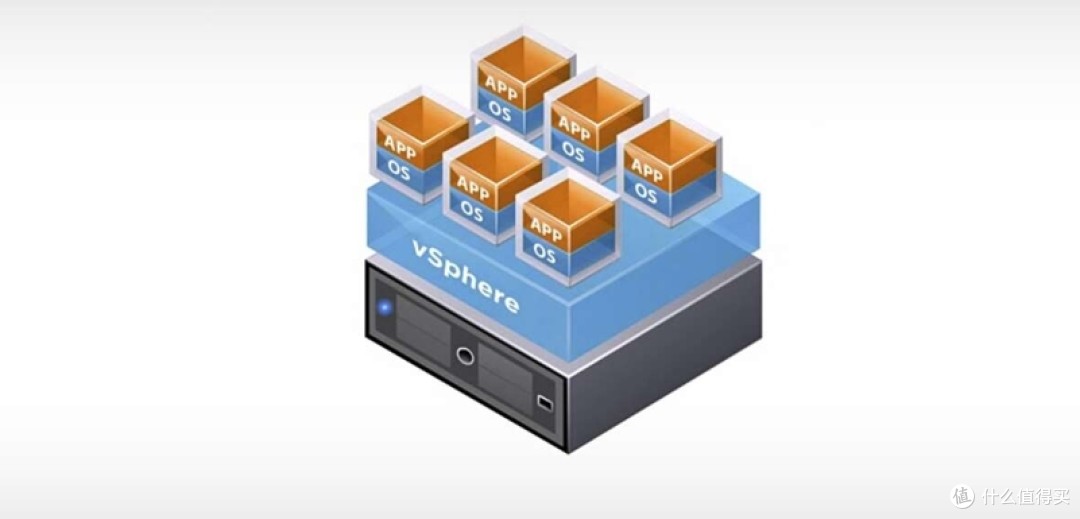

一、虚拟化

1. 什么是虚拟化

虚拟化,是指通过虚拟化技术模拟计算机的硬件,虚拟为多台逻辑计算机。在一台计算机上同时运行多个逻辑计算机,每个逻辑计算机可运行不同的操作系统,并且应用程序都可以在相互独立的空间内运行而互不影响,从而显著提高计算机的工作效率。

虚拟化使用软件的方法重新定义划分IT资源,可以实现IT资源的动态分配、灵活调度、跨域共享,提高IT资源利用率,使IT资源能够真正成为社会基础设施,服务于各行各业中灵活多变的应用需求。

2. 虚拟化软件的差别

Linux虚拟化软件:

qemu:软件纯模拟全虚拟化软件,特别慢!AIX,兼容性好!

Xen:性能特别好,需要使用专门修改之后的内核,兼容性差!

KVM:虚拟机,它有硬件支持CPU,基于Linux内核,而且不需要使用专门的内核!性能较好,兼容较好

VMware:图形界面,虚拟机管理管理软件,同时可运行多个操作系统在主系统的平台上,可以进行虚拟的分区、配置而不影响真实硬盘的数据,可通过网卡将虚拟机连为局域网,极其方便。

virtual box:号称最强的免费虚拟机软件,Oracle已收购,非常小。使用上和VMware差不多,有点耗CPU。

二、XenServer服务器虚拟化平台

1. 首先从Xen开始说起

Xen体系的架构

Xen 的 VMM ( Xen Hypervisor ) 位于操作系统和硬件之间,负责为上层运行的操作系统内核提供虚拟化的硬件资源,负责管理和分配这些资源,并确保上层虚拟机(称为域 Domain)之间的相互隔离。Xen采用混合模式,因而设定了一个特权域用以辅助Xen管理其他的域,并提供虚拟的资源服务,该特权域称为Domain0,而其余的域则称为Domain U。

其中最特殊的domain被称为Domain 0或VM 0,这是一个控制Domain,简称为Dom0,如上图左侧。

Domain 0除去包含了对应系统设备的所有驱动程序外,还有用来管理基于Xen系统的一个控制栈及多种系统服务。

通过Domain 0分解,可以将某些Domain 0中的服务及设备驱动拆出来,放在某专有虚拟机中运行,这需要一些特殊配置。

因此Xen就包含了三个部分:

Xen Hypervisor:

直接运行于硬件之上是Xen客户操作系统与硬件资源之间的访问接口。直接在硬件上运行,负责管理CPU、内存和中断。它是引导装载程序退出后运行的第一个程序。管理程序本身不处理I/O功能,如网络和存储。

Domain 0:

别名Dom0,这是一个特殊的虚拟机,运行在Xen管理程序之上,具有直接访问硬件和管理其他客户操作系统的特权的客户操作系统。没有Dom0,Xen hypervisor就不能使用。

Domain U:

运行在Xen管理程序之上的普通客户操作系统或业务操作系统,不能直接访问硬件资源(如:内存,硬盘等),但可以独立并行的存在多个。

Xen还提供了图形化管理工具XenCenter来管理资源。通过XenCenter 可以完成所有的配置操作,在实施中大部分配置操作都会通过该管理工具实现。

2. XenServer介绍

XenServer是一个由 Citrix 发起和管理的完整服务器虚拟化开源平台项目。

已同时针对 Windows 和 Linux 虚拟服务器进行了优化。

直接在服务器硬件上运行而不需要底层操作系统,因而是一种高效且可扩展的系统。

该项目开发的开源软件实现了虚拟化的多种功能,允许在硬件设备上安全地运行多个操作系统和应用程序,完成硬件整合和自动化。

工作方式是从物理机中提取元素(例如硬盘驱动器、资源和端口),然后将其分配给物理机上运行的虚拟机

VM 的运行方式与物理机十分相似,并且包含自己的虚拟(基于软件)CPU、RAM、硬盘和网络接口卡 (NIC)。

将静态、复杂的IT环境转变为更加动态、易于管理的虚拟数据中心,有效地降低IT资源成本,提供的先进管理功能,实现虚拟数据中心的集成和自动化,简化服务器和应用程序的管理。

XenServer的优点:

使用 XenServer 时,可以通过以下方式降低成本:

将多个 VM 合并到物理服务器上;

减少需要管理的单独磁盘映像的数量;

允许与现有网络和存储基础结构方便地集成。

使用 XenServer 时,可以通过以下方式提高灵活性。

允许使用 XenMotion 在 XenServer 主机之间实时迁移 VM,在确保零停机时间的情况下安排维护工作。

使用高可用×××配置相应策略(当一个 XenServer 主机发生故障时在另一个主机上重新启动 VM),从而提高 VM 的可用性,将一个 VM 映像用于一系列的部署基础结构中,从而提高 VM 映像的可移植性

XenServer体系的架构:

Citrix官网

Xen hypervisor直接运行在物理硬件上,负责处理CPU、内存、定时器和中断等相关任务。系统在完成引导加载程序后,Xen hypervisor首先启动。

XenServer 包含:

Xen 虚拟机管理程序:

此虚拟机管理程序是软件的基础抽象层。此虚拟机管理程序负责底层任务,

例如 CPU 调度,并且负责常驻 VM 的内存隔离。此虚拟机管理程序从 VM 的硬件提取。此虚拟机管

理程序无法识别网络连接、外部存储设备、视频等。

控制域:

也称作“Domain0”或“dom0”,控制域是一个安全的特权 Linux VM(基于 CentOS

v5.10 发行版),运行 XenServer 管理 toolstack。除了提供 XenServer 管理功能之外,控制域还

运行驱动程序堆栈,提供对物理设备的用户创建虚拟机 (VM) 访问。

管理 toolstack:

也称作 xapi,该软件 toolstack 可以控制 VM 生命周期操作、主机和 VM 网络连

接、VM 存储、用户身份验证,并允许管理 XenServer 资源池。xapi 提供公开记录的 XenAPI 管理接口,以供管理 VM 和资源池的所有工具使用。

VM 虚拟机

用于将受欢迎操作系统安装为 VM。也就是Xen当中的Domain U。

3. Xen与XenServer的区别

图中绿色框起来的部分就是Xen,红色框起来的部分就是XenServer

Xen就好比是汽车的发动机,而XenServer就是在Xen这台发动机的基础之上,给它安装上别的汽车零件,组装成一台可以在路上跑的汽车。

4. XenServer主机系统要求

XenServer的硬件兼容性列表_官网文档

XenServer 需要至少两台单独的 x86 物理计算机:一台作为 XenServer 主机,另一台运行 XenCenter 应用程序。

XenServer 主机计算机专用于运行托管 VM 的 XenServer,而不用于运行其他应用程序。

不支持直接在 XenServer 主机上(即,安装在 dom0 控制域中)安装任何第三方软件,但作为 增补包提供并且由 Citrix 明确认可的除外。

运行 XenCenter 的计算机可以是满足硬件要求的任何通用 Windows 计算机,也可用于运行其 他应用程序。

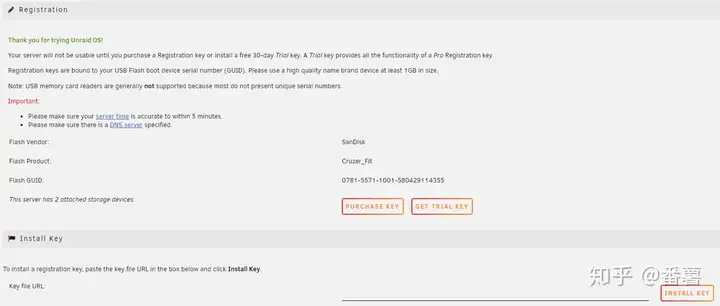

三、XenServer 安装步骤

官方文档

1. 版本选择

XenServer7.6发布于2018年9月5日,XenServer提供免费的开源版本;同时也保持了两个商用版本 Standard 和 Enterprise。

Standard Edition 是入门级商用产品,如果希望使用强大的高性能虚拟化平台,但不需要 Enterprise Edition 提供的高级功能,而同时仍希望获得全面的 Citrix 支持和维护保障,本版本提供的一系列功能可以满足此类客户的需求。

Enterprise Edition 是全功能高级版本,已针对服务器、桌面和云工作负载进行了优化。

这里暂时安装免费版

XenServer7.6官方安装文档-PDF

enServer 7.6免费版镜像下载地址;下载之前需要先注册一个Citrix账号

2. 主机系统要求

一个或多个64位x86 CPU,主频不低于1.5GHz,支持Intel VT或AMD-V

最低2GB内存

最低磁盘空间46GB

100Mbit/s或更快的网卡

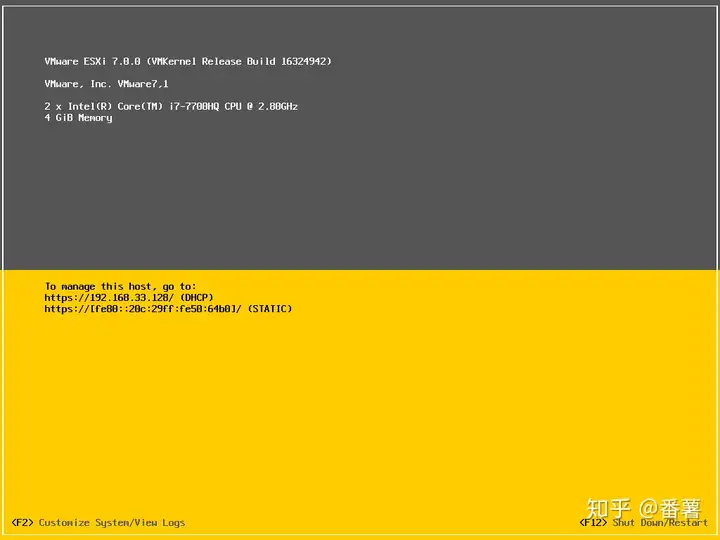

测试环境下没有多余的服务器,所以XenServer的安装将会部署到VMware虚拟机中。

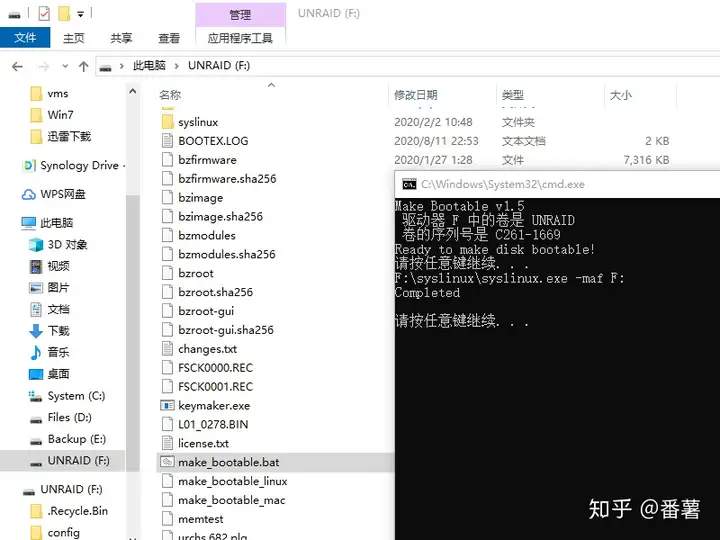

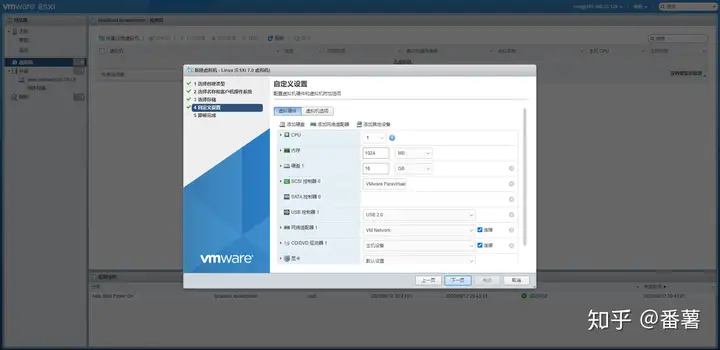

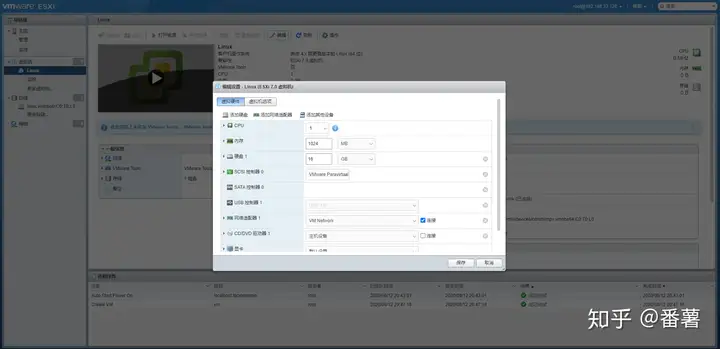

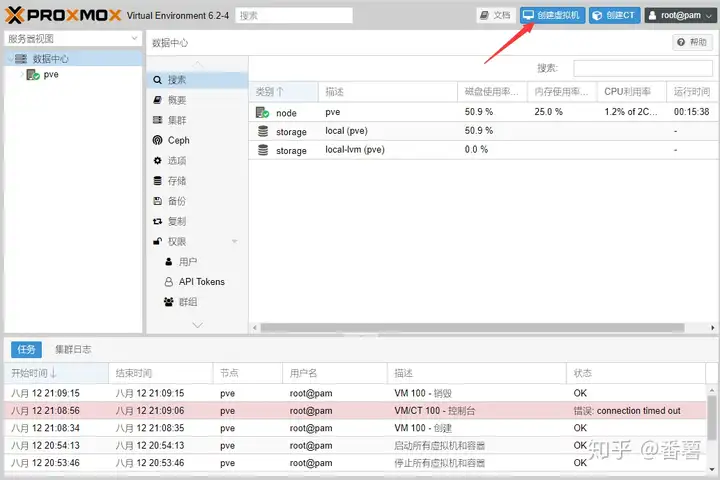

3. 新建虚拟机

因为没有Xen的选项,选择ESXI就可以了

磁盘容量建议给大一些200G+

4. XenServer引导安装

F2可以选择高级安装。正常情况下不需要用到高级安装,直接回车跳转到下一步

选择US→OK

继续点击OK

选择 Accept EULA

选定磁盘用于虚拟机存储,空格键选定磁盘及Enable thin provisioning后 OK继续

选择Local Media

选择 Skip verification , 跳过安装介质的检测

输入XenServer的root登陆密码

这里网络环境是桥接;所以直接选择默认;

如果定义管理网络IP地址,需要选择手动配置IP,输入IP、 掩码、 网关;

如果环境有多张网卡,则在此页面前有一个选择一个网卡作为管理网口的选项

配置主机名和DNS

选择 Asia(亚洲)

选择Shanghai 上海

选择Manual timeenty(手动输入时间)

也可以选择NTP时间同步,我们可以使用阿里云的NTP服务器地址 ntp1.aliyun.com

开始安装,点击Install XenServer——回车

安装过程中…

取消安装附加包

出现下面窗口,填入当前的正确日期时间

点击OK后自动重启

重启中

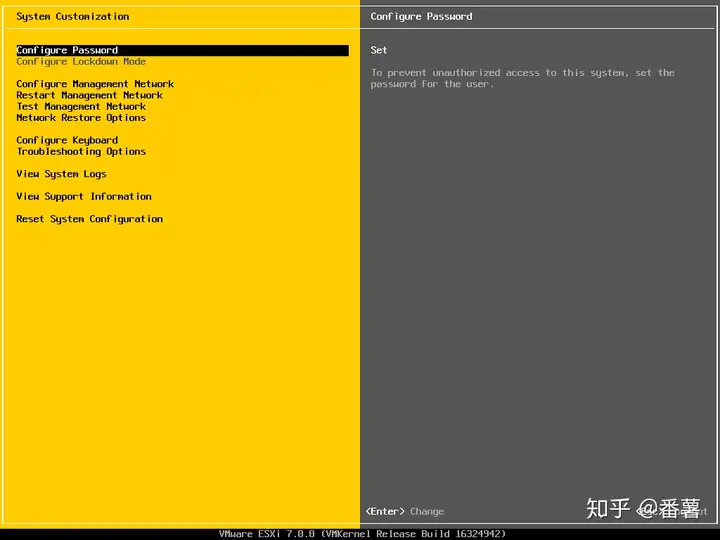

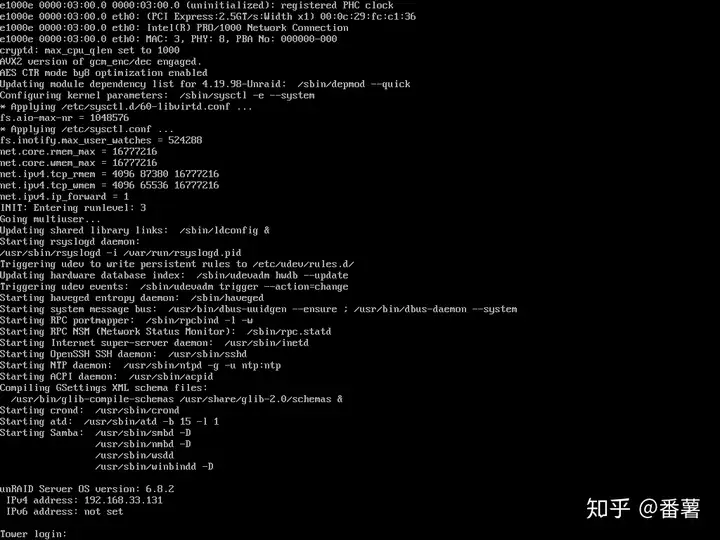

XenServer 7.6 启动完成,完成安装

XenServer 7.6 的界面管理翻译

5. 管理XenServer的方式

》XenServer 命令行界面 (CLI)

可以使用基于 Linux 的 xe 命令来管理 XenServer

也可以使用Xshell连接XenServer的命令行

》基于 Windows 的图形用户界面—XenCenter

三、客户端管理软件—XenCenter汉化版的安装

浏览器访问IP地址 http://10.0.0.72

点击XenCenter installer,下载XenCenter安装包,这里不推荐下载,可下载中文版

Xencenter7.6的汉化版 网盘提取码: t4ht

XenCenter官方下载链接

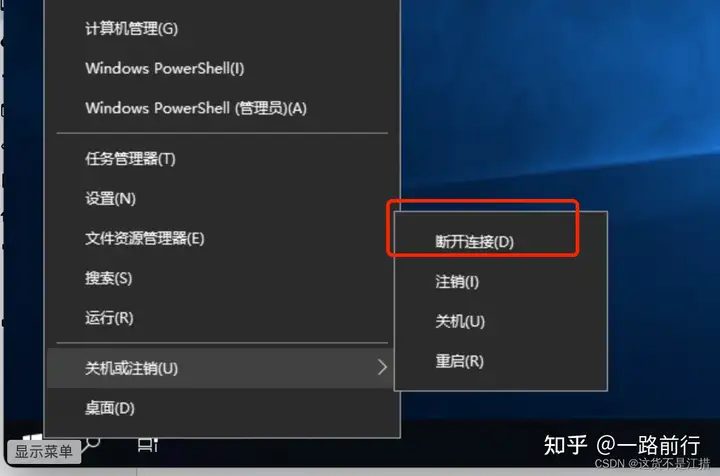

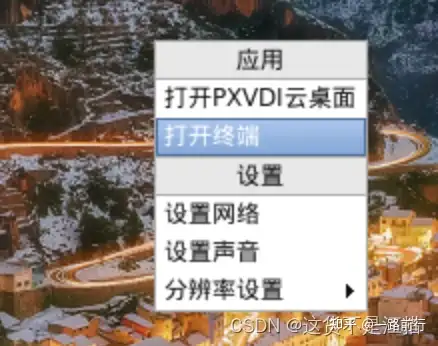

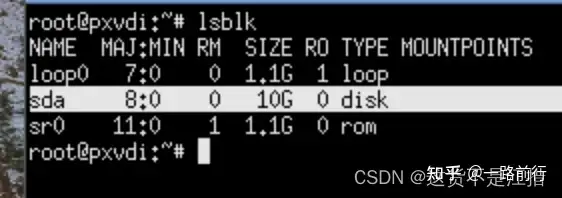

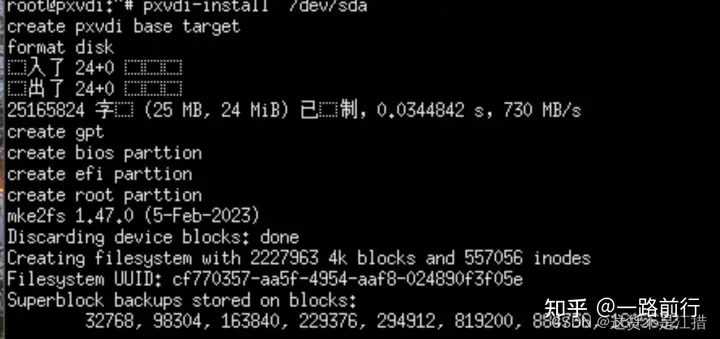

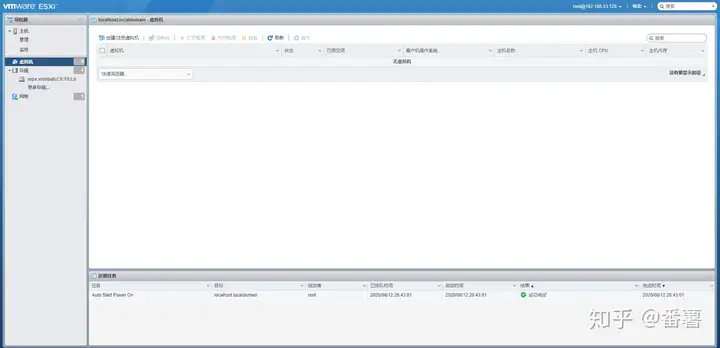

连接虚拟机

四、配置XenServer的YUM源

vi /etc/yum.repos.d/CentOS-Base.repo

# CentOS-Base.repo

#

# The mirror system uses the connecting IP address of the client and the

# update status of each mirror to pick mirrors that are updated to and

# geographically close to the client. You should use this for CentOS updates

# unless you are manually picking other mirrors.

#

# If the mirrorlist= does not work for you, as a fall back you can try the

# remarked out baseurl= line instead.

#

#

[base]

name=CentOS-$releasever - Base

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=os&infra=$infra

baseurl=http://mirror.centos.org/centos/7/os/$basearch/

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-7

#released updates

[updates]

name=CentOS-$releasever - Updates

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=updates&infra=$infra

baseurl=http://mirror.centos.org/centos/7/updates/$basearch/

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-7

#additional packages that may be useful

[extras]

name=CentOS-$releasever - Extras

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=extras&infra=$infra

baseurl=http://mirror.centos.org/centos/7/extras/$basearch/

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-7

#additional packages that extend functionality of existing packages

[centosplus]

name=CentOS-$releasever - Plus

#mirrorlist=http://mirrorlist.centos.org/?release=$releasever&arch=$basearch&repo=centosplus&infra=$infra

baseurl=http://mirror.centos.org/centos/7/centosplus/$basearch/

gpgcheck=1

enabled=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CentOS-7

=====================================================

yum repolist all

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

五、XenServer安装Centos8 虚拟机

1. 安装规划

\* 使用XenCenter创建Centos8虚拟机,安装Centos8系统,生成快照,并通过快照安装Centos8虚拟机

\* 下载Centos8安装的ISO文件

\* 使用本地的ISO作为储存库(SR),将Centos8的ISO文件上传到SR

\* 新建虚拟机并安装Centos8系统

\* 给虚拟机作初始化配置并生成快照

\* 根据快照快速安装Centos8虚拟机

\* 安装过程程需要使用到Xshell和Xftp工具,需要提前安装好

1

2

3

4

5

6

7

8

CentOS8镜像下载地址

2. 安装步骤规划

\* 使用Xshell连接XenServer服务器

\* 创建ISO库和本地存储库,并将centos8的ISO文件上传到SR

\* 打开Xftp,将Centos8的ISO文件上传至/boot-iso目录下

\* 进入XenCenter,连接上XenServer后刷新一下,选中新增加的boot-iso,选择Storage选项卡,点击Rescan,发现centos8的ISO文件

1

2

3

4

5

在虚拟环境中安装虚拟机需要用到ISO包,且虚拟机创建后需要一定空间来存储。这就分别需要用到ISO库和本地存储库

3. 创建ISO镜像库

XenServer 定义了一个名为存储库(SR) 的容器来描述存储虚拟磁盘映像 (VDI) 的特定存储目标。VDI是包含虚拟磁盘内容的磁盘抽象。

#新建iso存放目录

[root@XenServer7 ~]# mkdir /boot-iso/

#xe命令创建sr存储库

[root@XenServer7 ~]# xe sr-create name-label=boot-iso type=iso device-config:location=/boot-iso device-config:legacy_mode=true content-type=iso

[root@XenServer7 ~]# cd /boot-iso/

1

2

3

4

5

6

7

8

使用传输工具将镜像传送到/boot-iso/目录下

3.1 创建windows共享的ISO库

在XenCenter上添加SR库

添加成功

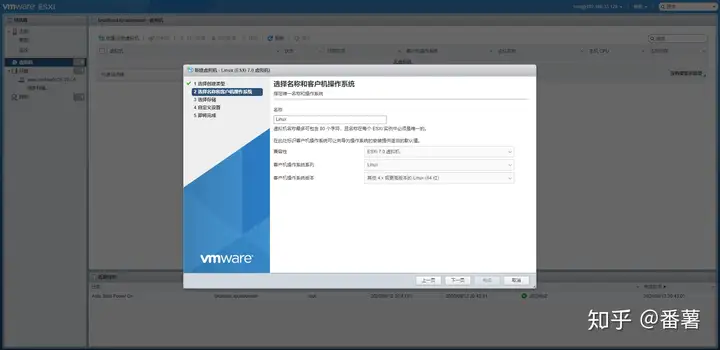

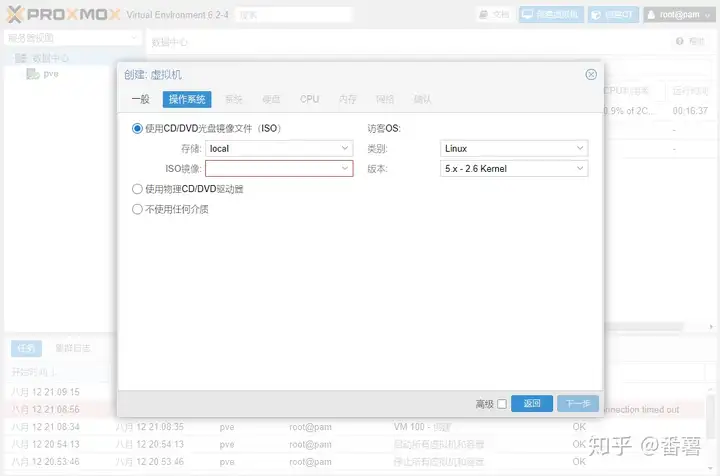

4. 新建虚拟机,按步骤配置

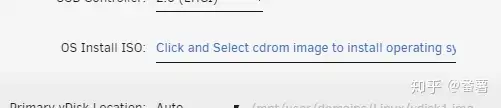

\* 选择安装的操作系统

\* 给vm取一个名字

\* 选择iso镜像

\* Home Server设置

\* CPU和内存设置

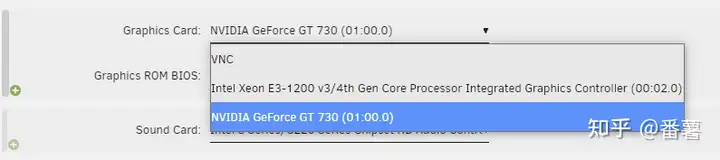

\* GPU设置

\* 存储设置

\* 网路设置

\* 完成

1

2

3

4

5

6

7

8

9

10

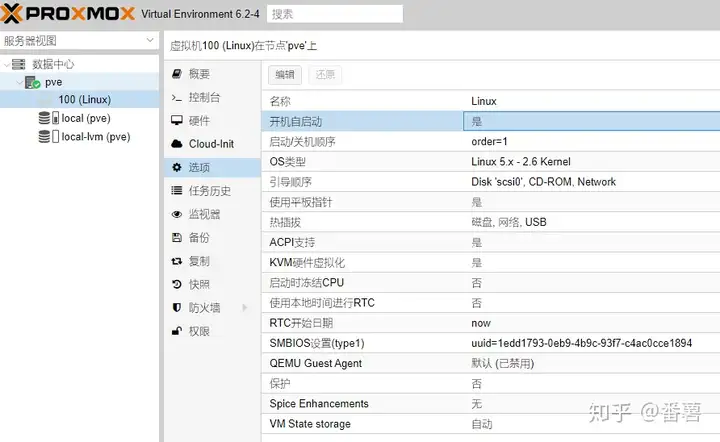

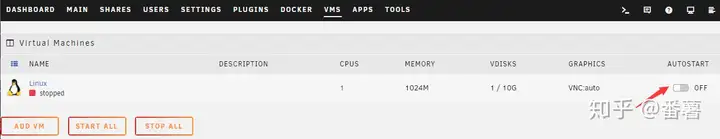

5. VM虚拟机创建完成

CentOS8的部署过程链接

6. 使用Xshell连上Centos8-node1虚拟机,进行基本的设置与生成快照

7. 利用快照文件快速的添加新的VM

\* 选中快照右键选择“New VM from Snapshot”

\* 参照前面新建VM过程,一直Next至完成,内存和磁盘大小最好保持不变

1

2

3

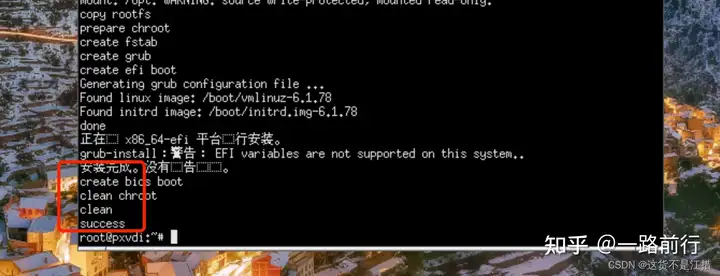

8. 安装 XenServer Tools

创建新的虚拟机开机后,在常规的虚拟化状态里会显示未安装XenServer Tools

这个XenServer Tools可以起到一个虚拟机的优化的作用,如果不安装,虚拟机的优化会受到很大的影响不仅仅windows可以按照XenServer Tools,在Linux上也可以安装。

点击框中的提示

XenCenter管理工具会自动将“XenServer Tools”光盘映像插入到该虚拟机的光驱中,接下来就是SSH方式登录到该虚拟机,执行剩余的安装步骤。

操作步骤如下:

[root@centos7-node1 ~]# cd /mnt/

[root@centos7-node1 mnt]# mkdir xenserver-tools

[root@centos7-node1 mnt]# mount /dev/cdrom /mnt/xenserver-tools/

mount: /dev/sr0 写保护,将以只读方式挂载

[root@centos7-node1 mnt]# cd xenserver-tools/Linux/

[root@centos7-node1 Linux]# ./install.sh

Detected `CentOS Linux release 7.6.1810 (Core) ' (centos version 7).

The following changes will be made to this Virtual Machine:

\* update arp_notify sysctl.

\* packages to be installed/upgraded:

- xe-guest-utilities-7.10.0-1.x86_64.rpm

- xe-guest-utilities-xenstore-7.10.0-1.x86_64.rpm

Continue? [y/n] y

准备中... ################################# [100%]

正在升级/安装...

1:xe-guest-utilities-xenstore-7.10.################################# [ 50%]

2:xe-guest-utilities-7.10.0-1 ################################# [100%]

You should now reboot this Virtual Machine.

[root@centos7-node1 Linux]#

[root@centos7-node1 Linux]# reboot #需要重启

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

记得拍摄快照

六、VM虚拟机的复制、导入导出

复制

用于生产使用,建议进行完整复制

用于测试使用,建议进行快速克隆

将每台虚拟机的存储名称都修改一下

导出

可以把虚拟机拷贝成文件,然后拷贝到别处,在另外一台虚拟机上把它导入进去。

导入

可以使用不同的虚拟化平台的虚拟机可以互相使用

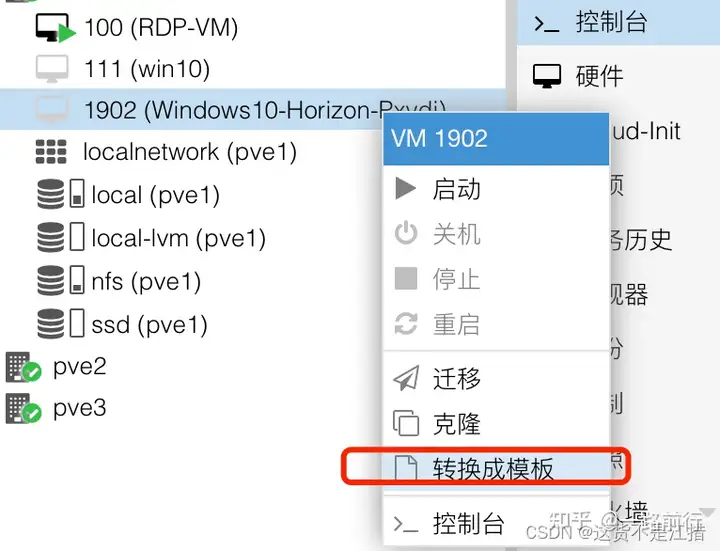

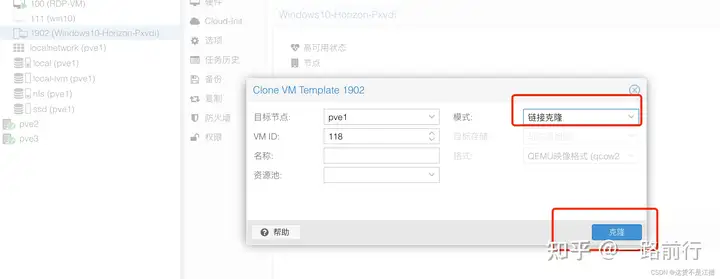

七、虚拟机模板创建与使用

创建模板

使用模板

创建完成

八、管理和配置存储

1. 本地存储

1.1 如果虚拟机的内存不够了,可以在存储中添加新的硬盘

··

fdisk /dev/xvdb 创建分区

mkfs.ext3 /dev/xvdb 格式化分区

mount /dev/xvdb /mnt/ 挂载分区

[root@centos7-node1 ~]# df -h

/dev/xvdb 4.8G 11M 4.6G 1% /mnt

1

2

3

4

5

6

7

1.2 磁盘的分离与连接

需要提前卸载掉磁盘后再进行分离

2. 配置网络存储

2.1 下载starwind工具

starwind安装手册

starwind下载地址

这里是免费版本,选择第二项

选择第一项Starwind

“Browse”: 选择下载的license文件,文件名称扩展名为".swk"

安装完成后启动管理控制台

2.2 创建管理控制台

2.3 回到XenCenter上创建存储库

3. NFS 存储

1. 搭建nfs服务器

nfs搭建步骤

#下载软件

yum install -y nfs-utils rpcbind

#启动rpcbind服务查看rpc服务注册信息

systemctl start rpcbind.service

rpcinfo -p

#启动nfs服务并查看注册信息

systemctl restart nfs

rpcinfo -p

#添加nfs配置文件

vim /etc/exports

#share /data

/data 10.0.0.22/24(rw)

#创建共享的目录并修改权限

mkdir /data

chown nfsnobody.nfsnobody /data

systemctl reload nfs

#检查 挂载

showmount -e

mount -t nfs 10.0.0.81:/data /mnt

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以戳这里获取

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

ZG4ubmV0L3FxXzM3MjQyNTIw,size_16,color_FFFFFF,t_70)

3. NFS 存储

1. 搭建nfs服务器

nfs搭建步骤

#下载软件

yum install -y nfs-utils rpcbind

#启动rpcbind服务查看rpc服务注册信息

systemctl start rpcbind.service

rpcinfo -p

#启动nfs服务并查看注册信息

systemctl restart nfs

rpcinfo -p

#添加nfs配置文件

vim /etc/exports

#share /data

/data 10.0.0.22/24(rw)

#创建共享的目录并修改权限

mkdir /data

chown nfsnobody.nfsnobody /data

systemctl reload nfs

#检查 挂载

showmount -e

mount -t nfs 10.0.0.81:/data /mnt

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

[外链图片转存中…(img-dDSeSgr3-1715892377652)]

[外链图片转存中…(img-fitBOFQJ-1715892377653)]

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以戳这里获取

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

————————————————

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

原文链接:https://blog.csdn.net/2401_84715583/article/details/138986440