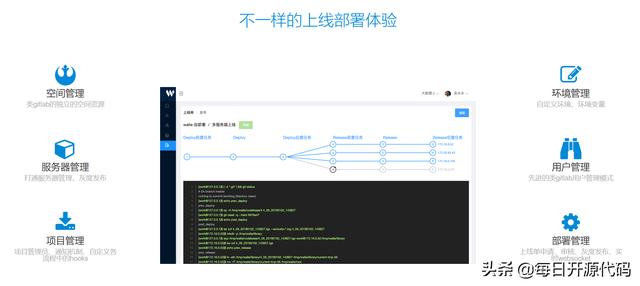

三分钟搭建超轻量级开源云平台(Nano)

基于KVM技术,使用Go语言开发,简单易学的虚拟机管理软件,从Web管理门户、主机监控、镜像克隆到故障切换,功能完备,开箱即用,数分钟之内即可将您的服务器集群升级为云主机平台。

快速安装指引

Nano平台提供了Installer安装程序用于自动化部署,最新版本Installer可以通过 官网下载 或者 Github发布页面 获取。

Installer会自行选择最合适的配置进行建议, 对于初次安装Nano的新用户,安装过程中尽量不要调整任何参数 ,如需调整参数、修改配置或者直接升级二进制文件,请在熟悉产品后进行操作。

Nano云平台可以将所有模块部署在同一个服务器或者虚拟机,实现All In One的最小验证集群

请使用前务必阅读快速入门手册,熟悉相关概念和流程再进行操作

服务器要求

支持虚拟化的X86服务器或者打开嵌套虚拟化(Intel VT-x/AMD-v)的虚拟机

2核4G内存50GB磁盘和一个网络设备

CentOS 7 Minimal

操作系统安装完成并且网络就绪

Firewalld和Selinux服务正常运行

如有Raid/LVM请先完成配置,再进行Nano安装

默认情况下"/var/lib/libvirt/images"路径存储云主机磁盘文件,"/opt/nano/core/data"存储系统镜像文件,请为其保留足够空间

全新安装

第一步. 下载并安装所有模块

$wget https://nanos.cloud/files/nano_installer_1.3.0.tar.gz $tar zxfv nano_installer_1.3.0.tar.gz $cd nano_installer $./installer

输入"0,1,2"或者"3"在当前服务器安装所有模块. 当您第一次安装Nano时,建议您使用安装程序建议的默认配置,无需修改。 如果你有多个网卡设备,请在安装程序的提示中选择连接内网的网卡设备进行安装。

配置详情可参考 快速入门手册

第二步. 启动所有服务

模块安装完成后,需要启动模块以提供服务,模块默认安装在/opt/nano目录下。使用命令手动启动所有模块(假定所有模块安装在同一台服务器), 请注意,必须首先启动Core模块 。

$cd /opt/nano/core $./core start $cd ../cell $./cell start $ cd ../frontend $./frontend start

我写成一键启动脚本

cat start.sh

#!/bin/bash

#

ps -ef | grep core | grep -v grep |awk '{print $2}' |xargs kill -9 &> /dev/null

ps -ef | grep cell | grep -v grep |awk '{print $2}' |xargs kill -9 &> /dev/null

ps -ef | grep frontend | grep -v grep |awk '{print $2}' |xargs kill -9 &> /dev/null

cd /opt/nano/core

./core start

cd /opt/nano/cell

./cell start

cd /opt/nano/frontend

./frontend start

当front-end模块成功启动后,会提示一个形如"x.x.x.x:5870"的监听地址,使用Chrome或者Firefox打开这个地址就可以进行平台管理了。

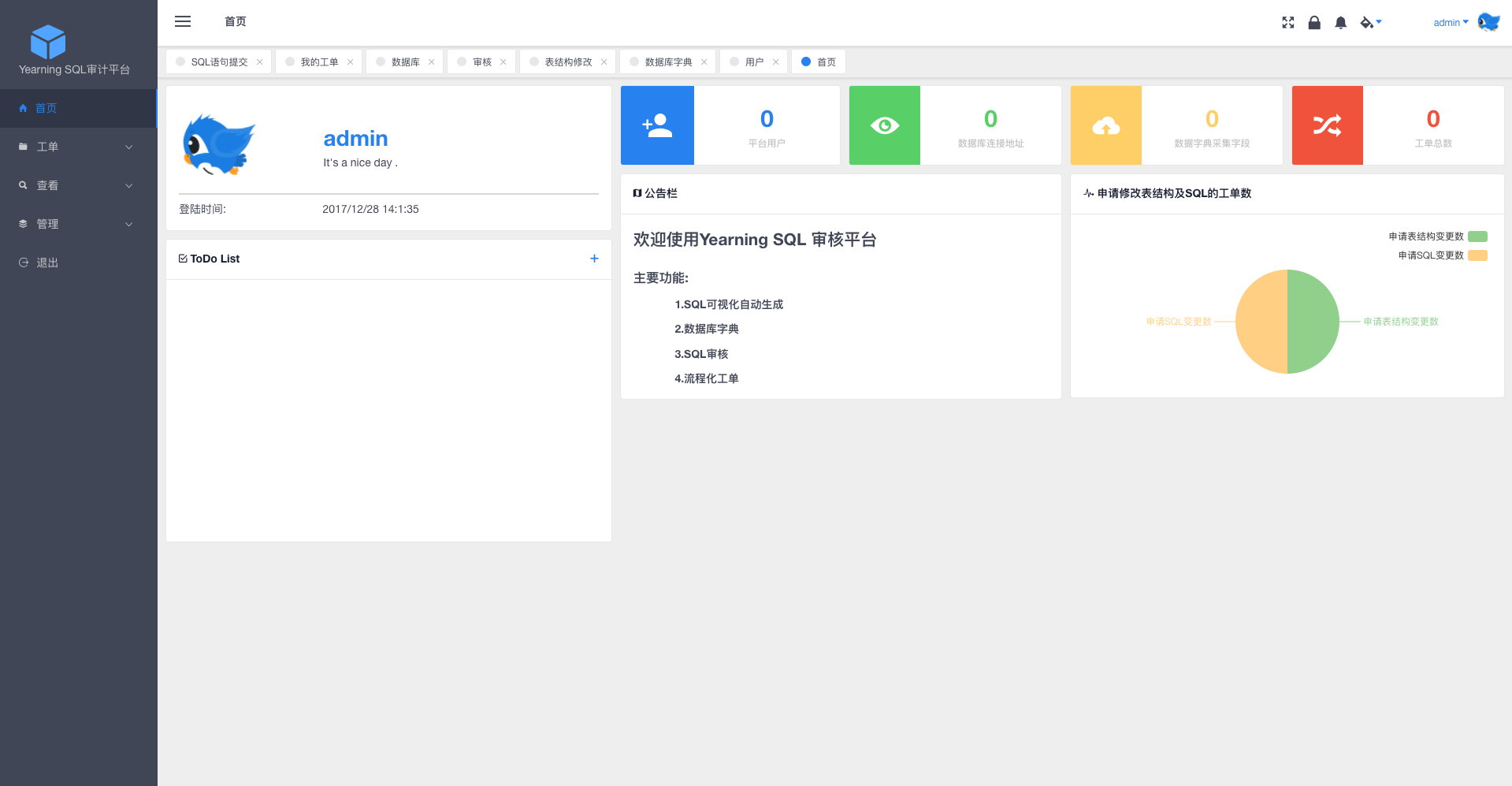

第三步. 使用Web门户管理平台

在浏览器中首次打开Nano管理页面,会提示创建一个初始管理员,成功后就可以登录平台。

登录系统之后,参考配置手册在计算资源池里添加资源节点之后,就可以开始创建云主机实例了。你也可以上传或者构建新的光盘镜像或者磁盘镜像,用于快速批量部署实例。

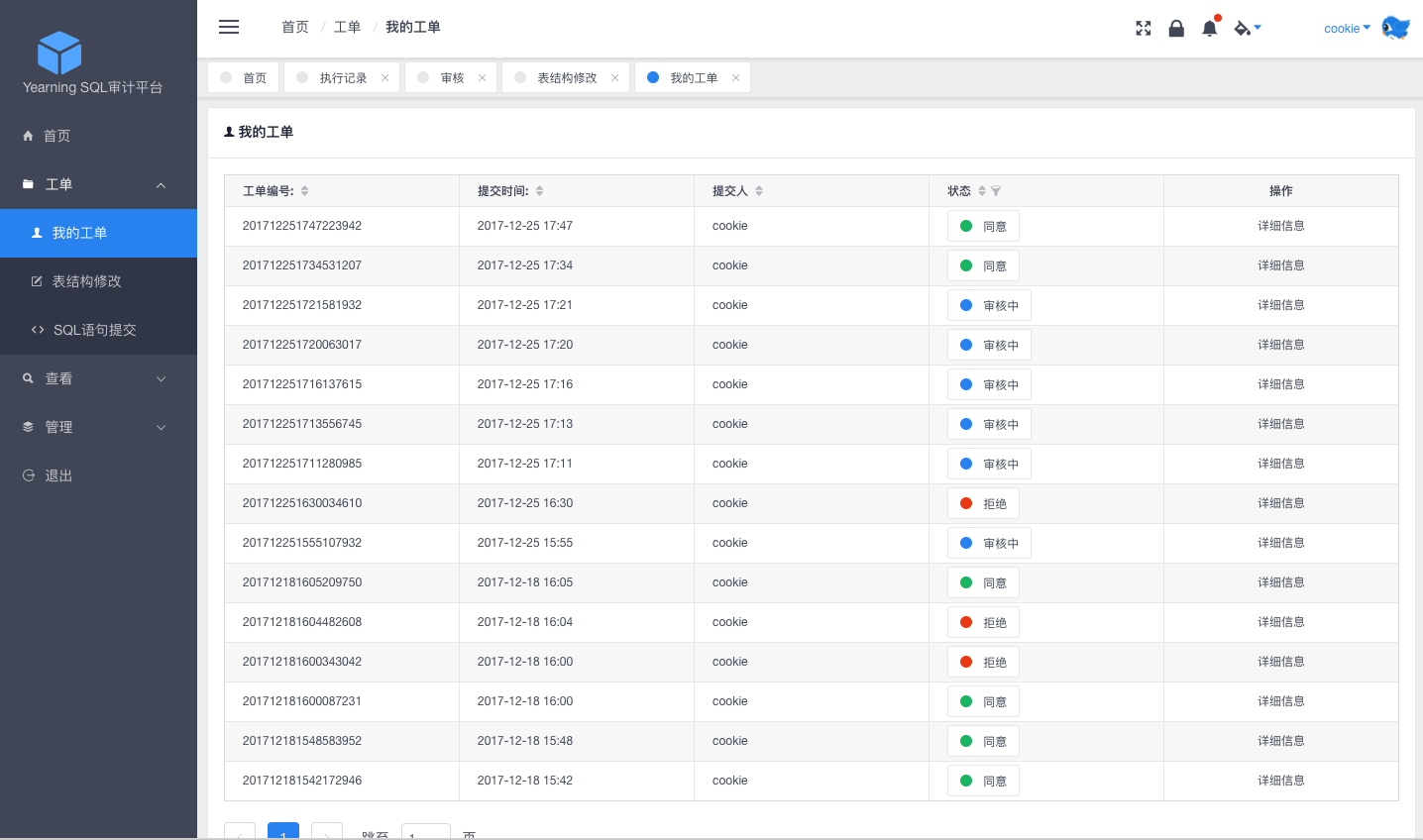

配置服务

选择-计算资源池-使用本地存储-资源节点

将本机加入到资源节点中来

默认的资源节点为/var/lib/libvirt/images

"/opt/nano/core/data"存储系统镜像文件

可以修改为自己定义的位置

选择光盘镜像上传一个下载的iso镜像文件

选择云主机-创建云主机-定义云主机的信息-来源镜像选择空白镜像(因为我这里是加载的iso镜像-需要安装系统)

选择加载刚才的光盘镜像

选择远程监控-可以看到正在安装系统

还能对已经运行的云主机进行资源的监控

这里简单的实现了云主机实列的创建应用。还有一些其他强大的功能还未探索 重点是使用极为方便,部署工作三分钟搞定。

升级安装

Nano所有模块使用go编译为二进制可执行文件,无需外部库依赖,配置和数据文件格式通常保持后向兼容,无需用户干预。

Nano能够通过两种方式进行升级,启动Installer并且选择”4”可以进行自动升级,自动升级会根据用户输入的安装路径,检查已经安装模块进行替换,并且自动停止并重启运行中的模块,是推荐的升级方式。

当自动升级方式出现问题时,可以选择手动升级,只需要使用”./模块名 stop”停止运行中的模块文件,替换可执行文件后使用”./模块名 start”重新启动服务即可。

唯一例外是FrontEnd模块还包含前端页面文件,所以升级时,除了要替换可执行文件,还需要手工将页面和js脚本文件从发布包中复制resource目录下进行覆盖。

————————————————

版权声明:本文为CSDN博主「姚敦林博客」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/yaodunlin/article/details/111645027